はじめに

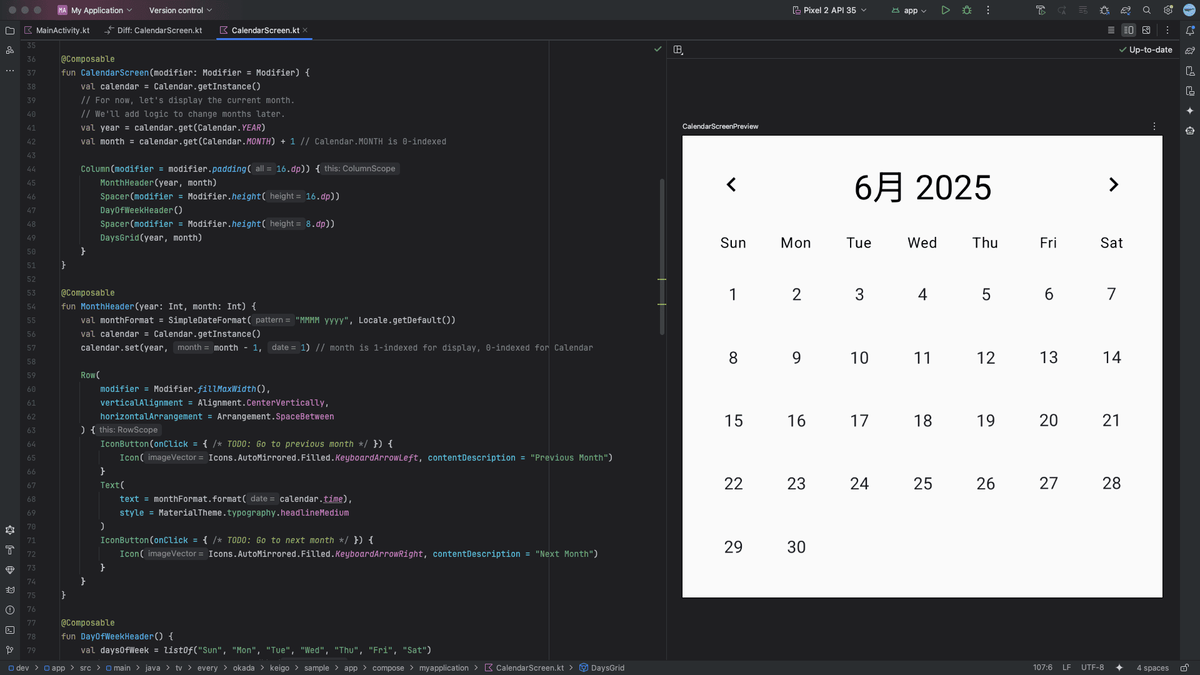

こんにちは。リテールハブ開発部の池です。

昨今、AI を活用したコードレビューの方法は日を追うごとに選択肢が増えているように思います。

- GitHub Copilot - GitHub 上の PR に対して レビューコメントを自動生成

- Claude Code -

/reviewコマンドを使ったローカルレビューや、Claude Code Actions による GitHub 上の PR レビュー - Cursor -

.cursorrulesファイルでカスタムルールを定義してのローカルレビューや、Cursor BugBot による GitHub 上の PR レビュー

このように、各ツールがローカルでのレビューと PR レビューの両方に対応しており、様々なレビューの方法があります。

今回は、2025 年 5 月に無料でリリースされた CodeRabbit VSCode 拡張機能を試してみました。PR レビューで有名な CodeRabbit ですが、ローカル環境でリアルタイムにコードレビューできるようになったということで、使い方を含め紹介できればと思います。

なお、今回の検証はCursorを使って行いました。VSCode 拡張機能として提供されていますが、Cursor でも問題なく動作することを確認しています。

CodeRabbit とは

CodeRabbit は、AI を活用した自動コードレビューツールです。元々は GitHub、GitLab、Bitbucket などと連携し、PR に対して自動的にレビューコメントを付けることで知られています。 これまでは主に有料会員に対する PR ベースのレビューが中心でしたが、2025 年 5 月に VSCode 拡張機能がリリースされ、ローカル開発環境でもその恩恵を受けられるようになりました。

詳しくは公式ページをご参照ください。

CodeRabbit VSCode 拡張機能

CodeRabbit VSCode 拡張機能は、ローカルの IDE 内でコードレビューを受けられる拡張機能です。この機能によって、PR を作成する前に問題を発見・修正できるため、開発効率の向上が期待できます。

主な特徴として以下があげられます。詳しくは公式ブログをご参照ください。

コンテキストを理解した高品質なレビュー

- 単純な文法チェックだけでなく、コードの文脈を理解して意味のあるレビューを提供

- 関数の使い方、変数の命名、コードの構造など、様々な観点から改善提案

リアルタイムレビュー

- 設定によってはコミット時に自動的にレビューが実行される

- PR を作成する前に品質を向上させることができ、レビュアーの負担も軽減

- 未コミットの変更に対してもレビューを実行可能

AI による修正提案

- 問題点を指摘するだけでなく、具体的な修正案も提示

- 「Fix with AI」ボタンをクリックすることで、Claude Code, Cline, Roo など AI エージェントと連携して自動修正も可能

幅広い言語サポート

- JavaScript、TypeScript、Python、Java、C#、Go、Ruby など、主要なプログラミング言語をサポート

- 言語に応じた適切なレビューを提供

料金

CodeRabbit の料金体系は以下です。

※ 2025 年 7 月 8 日時点の情報なのでご注意ください。最新の料金情報は公式料金ページをご確認ください。各プランの詳細な利用制限については公式 FAQをご確認ください。

プラン比較

| プラン | 月額料金 | VSCode 拡張機能レビュー回数 | PR レビュー | 主な機能 |

|---|---|---|---|---|

| Free | 無料 | 1 時間あたり 1 回 | 基本機能のみ | ・PR 要約 ・無制限のリポジトリ ・14 日間の Pro 無料トライアル |

| Lite | $12/月(年間契約) $15/月(月次契約) |

1 時間あたり 1 回 | 拡張機能 | ・無制限の PR レビュー ・カスタマイズ可能な学習機能 ・リアルタイム Web 検索 ・コードグラフ分析 |

| Pro | $24/月(年間契約) $30/月(月次契約) |

1 時間あたり 5 回 | 高度な機能 | ・Lite の全機能 ・Linter/SAST ツール対応 ・Jira/Linear 連携 ・エージェントチャット ・分析ダッシュボード |

| Enterprise | カスタム価格 | 要相談 | 全機能 | ・Pro の全機能 ・セルフホスティング対応 ・SLA サポート ・専任カスタマーサクセスマネージャー ・カスタムインテグレーション |

VSCode 拡張機能だけを使う分には無料なので、まずは気軽に試すことができるのが大きな魅力だと思います。ただし、無料プランでは 1 時間に 1 回という制限があるため、頻繁にレビューを実行したい場合は Pro 以上のプランを検討が必要になります。

試してみる

導入手順

1. 拡張機能のインストール

VSCode(今回は Cursor)の拡張機能タブから「CodeRabbit」を検索してインストールします。

2. ログイン

インストール後、ログインが必要です。GitHub、GitLab、Azure DevOps、Bitbucket のいずれかのアカウントでログインできます。

3. 設定(オプション)

必要に応じて以下の設定を調整できます。

- Auto Review Mode: コミット時の自動レビューの有効/無効

- AI Integration: Claude Code, Cline, Roo など AI エージェントとの連携設定

- Review Timeout: レビューのタイムアウト時間(デフォルト 20 分)

レビューの実行方法

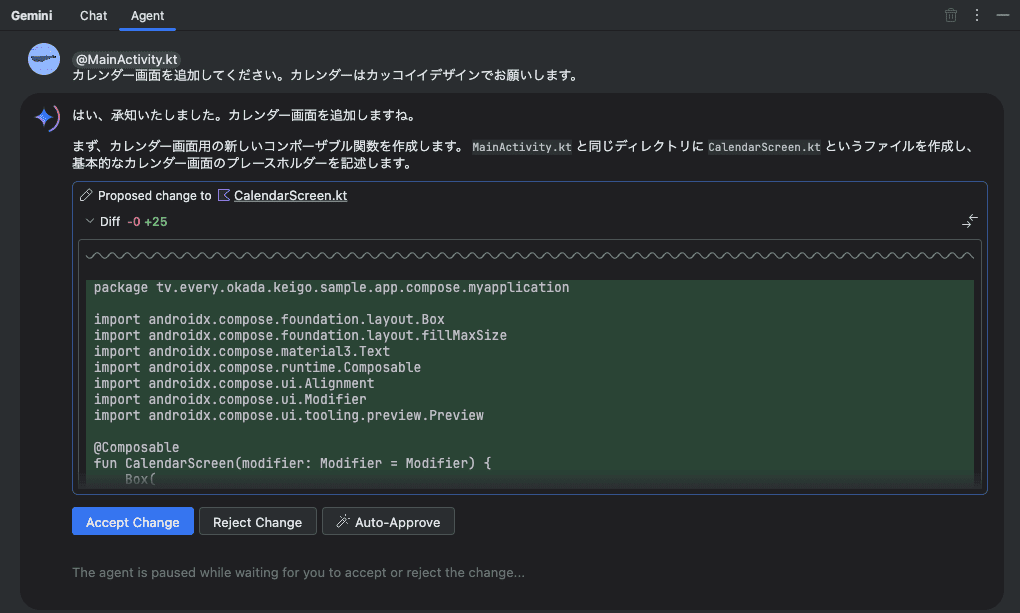

CodeRabbit には 2 つのレビュー開始方法があります。

自動レビュー Git コミット後に自動的にダイアログが表示され、レビューを実行できます。

手動レビュー VSCode アクティビティバーの CodeRabbit アイコンをクリックして、以下の 3 つのモードから選択してレビューを実行できます。

- Review uncommitted changes: 未コミットの変更のみをレビュー

- Review committed changes: コミット済みの変更のみをレビュー

- Review all changes: ベースブランチとの差分すべて(コミット済み+未コミット)をレビュー

詳細な使い方

設定へのアクセス

CodeRabbit の設定は、サイドバーの右上にある歯車アイコンからアクセスできます。

Auto Review Mode 設定

コミット後の自動レビューの動作を制御。

- Disabled: 自動レビューを完全に無効化

- Prompt: コミット後に確認ダイアログを表示(デフォルト)

- Auto: 確認なしで自動的にレビューを開始

Agent Type(AI 統合)設定

「Fix with AI」機能で提案された修正を適用する方法を選択できます。

- Native: VSCode の GitHub Copilot を使用(VSCode のみ対応)

- Claude Code: ターミナルで Claude コマンドを実行(Claude Code のインストールが必要)

- Codex CLI: Codex CLI ツールを使用

- Cline: Cline 拡張機能を使用

- Roo: Roo Code を使用

- Kilo Code: Kilo Code 拡張機能を使用

- Clipboard: 修正提案をクリップボードにコピー(手動で AI ツールに貼り付け)

Review Timeout 設定

レビューのタイムアウト時間を分単位で設定できます。

デフォルトは 20 分ですが、0 に設定するとタイムアウトを無効化できます。

ベースブランチの選択

レビュー時に比較対象となるブランチを手動で選択できます。デフォルトでは現在のブランチの親ブランチが自動選択されますが、任意のローカルブランチを選択可能です。

サイドバーに現在のブランチと比較対象のブランチが表示され、クリックすることで変更できます。

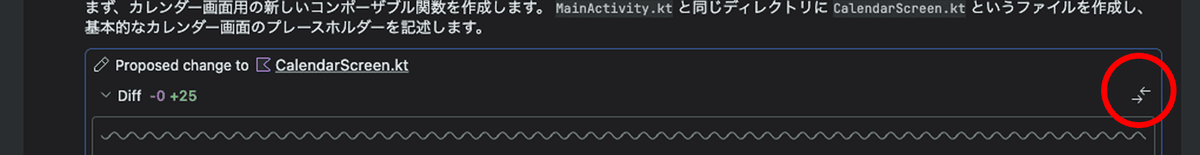

レビューの実行状況

レビュー実行中は、サイドバーでリアルタイムに進捗を確認できます。

「Setting up」→「Analyzing changes」→「Reviewing files」の順に処理が進み、レビュー対象のファイルがリスト表示されます。

過去のレビュー履歴

サイドバーの「Previous reviews」セクションで、過去に実行したレビューの結果を確認できます。これにより、修正の進捗を追跡しやすくなります。

過去のレビューには「cancelled」などのステータスも表示され、レビューの完了状況を把握できます。

レビュー機能を試してみました

実際に CodeRabbit がどのようなレビューをしてくれるのか、具体例を見てみましょう。

例 1: 既存コードスタイルへの統一提案と最新情報を踏まえた提案

ECS タスク定義の JSON ファイルをレビューした際の結果です。

CodeRabbit は以下の 2 つの指摘をしています。

クォートスタイルの統一

- ダブルクォートとシングルクォートが混在していることを指摘

- 既存のコンテナ定義がシングルクォートを使用しているため、それに合わせるべきという提案

Datadog Agent のバージョン更新提案

- 現在のバージョン 7.67.0 から 7.67.1 へのアップデートを提案

- CVE-2025-4565 と CVE-2025-49128 の脆弱性修正が含まれていることを明示(※ CodeRabbit は特定の脆弱性修正を理由として挙げていますが、実際の修正内容については公式リリースノートで確認することを推奨します。今回の指摘内容は issue で報告されている内容でした。)

特に注目すべきは、セキュリティ脆弱性情報を踏まえたバージョン更新の提案です。単純な構文チェックだけでなく、セキュリティの観点からもレビューを提供していることがわかります。(注意: AI レビューツールの指摘については、常に公式情報源での確認が重要です。)

また、バージョン 7.67.1 は 5 日前にリリースされたばかりの最新のバージョンだったのですが、そのような新しい情報を踏まえたレビューを行なっていることがわかります。

例 2: 複数ファイルにまたがる一貫性の確認

別のファイル(secrets.libsonnet)でも同様の指摘がありました。

プロジェクト全体の一貫性を保つため、同じ指摘であっても複数のファイルにまたがって同じ観点でレビューしてくれます。

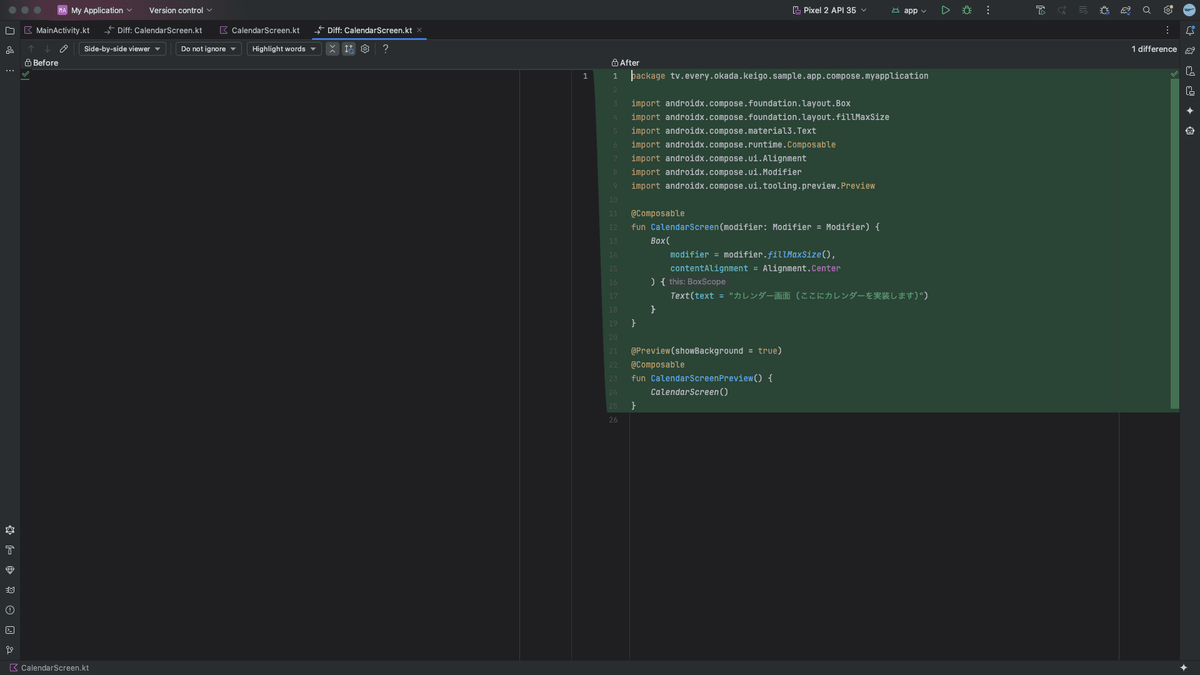

例 3: レビューコメントを反映する機能

レビューコメントへの対応方法は 2 つあります。

- Apply suggested change - 提案された変更を直接適用する場合

- Fix with AI - AI ツールを使って対話的に修正する場合

「Apply suggested change」をクリックすると、CodeRabbit が提案した修正内容がそのまま適用されます。シンプルな修正の場合はこの方法が最も効率的です。一方、「Fix with AI」ボタンをクリックすると、選択した AI ツールで自動的に修正を適用できます。

Fix with AI による修正例

以下は、PHP コードでの冗長な例外処理に関する NITPICKS レビューの例です。

この NITPICKS レビューで「Fix with AI」ボタンをクリックすると、設定した AI ツール(この例では Claude Code)がターミナルで起動します。

Claude Code は問題を分析し、以下のような修正を提案します。

- 冗長な

match式の削除 - デフォルト値が同じケースの簡略化

- コードの可読性向上

私の環境では、CodeRabbit 拡張機能の設定画面で Agent Type 設定を「Claude Code」にしているため、ボタンをクリックするとターミナルで Claude コマンドが実行され、提案された修正を対話的に確認しながら適用できます。

例 4: レビューの種類別表示

CodeRabbit は指摘の種類によって異なるラベルと色で表示します。

赤い「Potential Issue」ラベル - 潜在的な問題を示すレビューです。上記の例では、より適切なメソッドの使用に関する指摘(save()よりupdate()を使うべき)などが含まれています。

青い「Refactor Suggestion」ラベル - コードの改善提案を示すレビューです。この例では、PHP のメソッドに型ヒントを追加することで、型安全性と IDE 支援を向上させる提案がされています。

その他にも「Verification」という緑のラベルもありました。

所感

CodeRabbit VSCode 拡張機能を実際に使ってみて、以下の点が特に印象的でした。

良かった点

- レビューの的確さ - 単純な構文エラーだけでなく、コードの一貫性や保守性の観点からもレビューしてくれる

- 最新情報への対応 - 5 日前にリリースされたばかりの最新バージョンに関する指摘もあり、最新情報を踏まえたレビューをしてくれた

- レスポンスの速さ - コミット後すぐにレビューを実行できる

- 無料で使える - これだけの機能が無料で使えるのは驚き

実際のパフォーマンス

Laravel で 34 ファイル、合計 1,000〜2,000 行程度のコード変更をレビューした際の比較です。詳細は割愛しますが、内容は単純な CRUD の REST API 実装で、複雑なロジックを含まないような実装です。

※ この結果はあくまで Laravel で単純な CRUD の REST API 実装で試した結果であり、参考程度にご覧ください。言語、プロジェクトの規模や複雑さなど、様々な要因によって結果は異なると思います。

CodeRabbit VSCode 拡張機能

- レビュー時間:5〜10 分

- レビューコメント数:約 40 個

- 同様の問題が複数箇所にある場合も、すべて個別にコメント

- セキュリティ観点のレビューコメントもあり

GitHub Copilot(参考)

- レビュー時間:CodeRabbit より高速

- レビューコメント数:2 個

- REST に準拠した適切な HTTP ステータスコードの使用に関するコメント

- 複数ファイルにおける status の整合性に関するコメント

今回の例に関しては、レビューの速度については GitHub Copilot の方が早い一方で、CodeRabbit はより網羅的で細かなレビューを提供してくれました。

まとめ

CodeRabbit VSCode 拡張機能は無料プランの場合回数制限がありますが、機能を試すことは可能なので、まずは使ってみることをおすすめします。手元で実装した内容をその場ですぐにレビューできるのはとても便利で、レビュー効率を高めることができると思います。

CodeRabbit は今後も機能拡張が予定されているようなので、さらなる進化に期待したいと思います。